6. EVALUACIÓN

La evaluación del modelo se planteó como un proceso rigurosamente controlado y transparente, con el objetivo de garantizar que los resultados aportaran valor medible frente a los métodos ingenuos de referencia que utiliza el equipo de FM en la actualidad.

-

Métricas de Evaluación

Se utilizaron métricas complementarias, tanto absolutas como relativas, para manejar la alta intermitencia y la presencia de valores cero en las series:

-

MAE (Error Absoluto Medio): Indicador de error absoluto a nivel individual de serie.

- WAPE (Error Porcentual Absoluto Ponderado): Métrica intuitiva a nivel portfolio, ya que relaciona el error total con el volumen real total. Fue la métrica preferida para comunicar y evaluar con el equipo de FM el rendimiento global (ver Anexo 1).

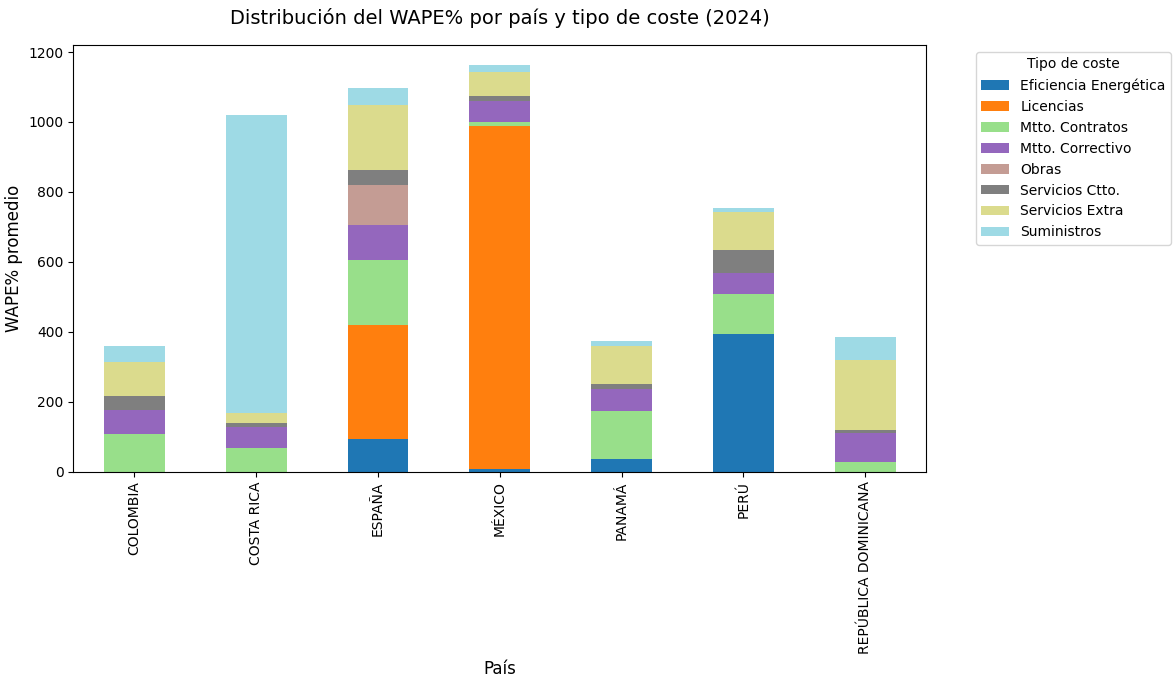

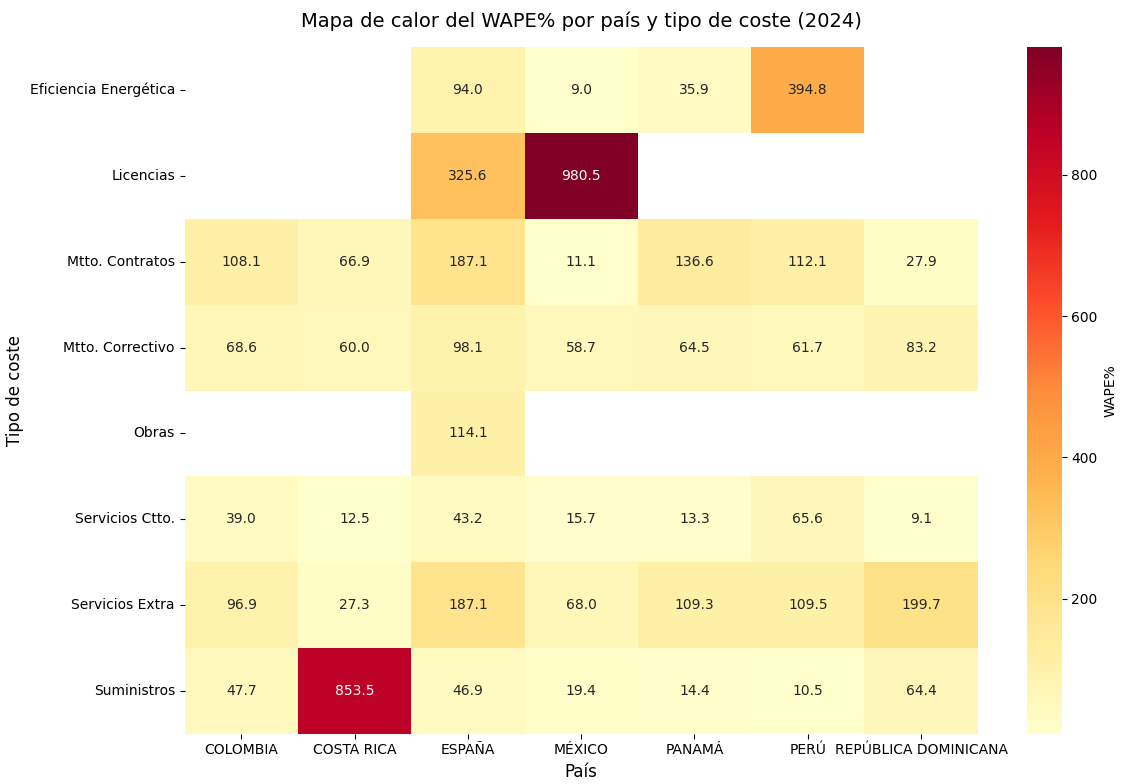

Ejemplo 1: El gráfico nos revela que el modelo resultado de la estrategia 3 tiene áreas críticas localizadas (ej. México y Costa Rica, donde un coste domina el error) y áreas más complejas (España y Perú, con varios tipos de coste contribuyendo). Esto sugiere que las estrategias de mejora deberían diferenciarse por país, focalizando en la categoría dominante allí donde sea un único coste el que concentra los problemas.

- SMAPE (Error Porcentual Absoluto Simétrico): Más robusta frente a escalas muy distintas de coste.

- MASE12 (Error Escalonado Medio Absoluto, referencia estacional): Métrica de gobernanza principal. Un valor MASE12 < 1 implica que el modelo supera al baseline SNaive12.

-

Metodología de Validación

-

Validación Cruzada con Rolling Origin (Paso 4):

Se realizaron validaciones móviles sobre la ITE1 (serie de 2021 a 2023), asegurando que la selección de modelos fuera representativa de los distintos patrones temporales. Esto permitió elegir un Top1 y Top-2 de modelos por serie.

-

Criterio de Gobernanza (Paso 6):

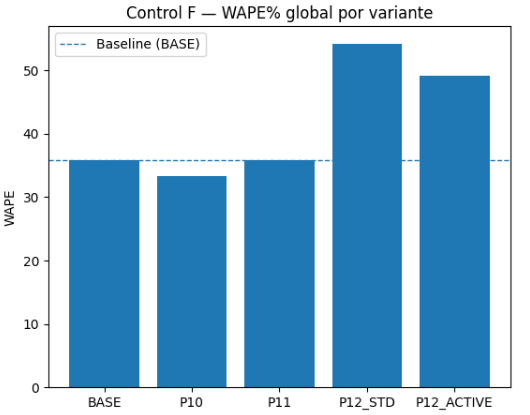

El control clave fue el Control F, que establecía dos condiciones:

-

A nivel portfolio anual: el WAPE no podía empeorar frente al baseline.

-

A nivel serie: si el MASE12 de un modelo avanzado no superaba al SNaive12, se aplicaba un reemplazo forzado por el baseline.

Ejemplo 4: Con la Estrategia 3, el modelo de reconciliación P10 mejora el baseline global (0.3588 vs 0.3923). P11 es similar o mejor en algunos países y ciertos tipos de coste; P12_STD introduce inestabilidad y empeora de forma pronunciada; si se aplica una capa “activa/gobernada”, corrige parte del daño pero no se recomienda como opción por defecto frente a P10.

-

Impacto de la inestabilidad (Estrategia 2):

Se evidenció que solo entre un 15% y un 18% de las series eran realmente estables. Esto implicó que métricas como WAPE y SMAPE tuvieran valores altos, debido a:

- Intermitencia en los consumos.

- Aparición de picos puntuales.

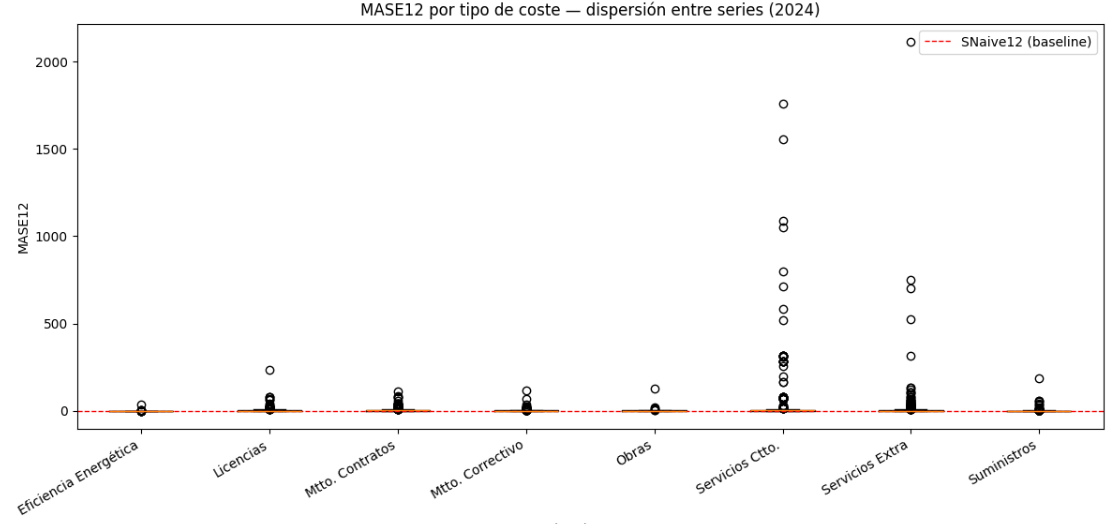

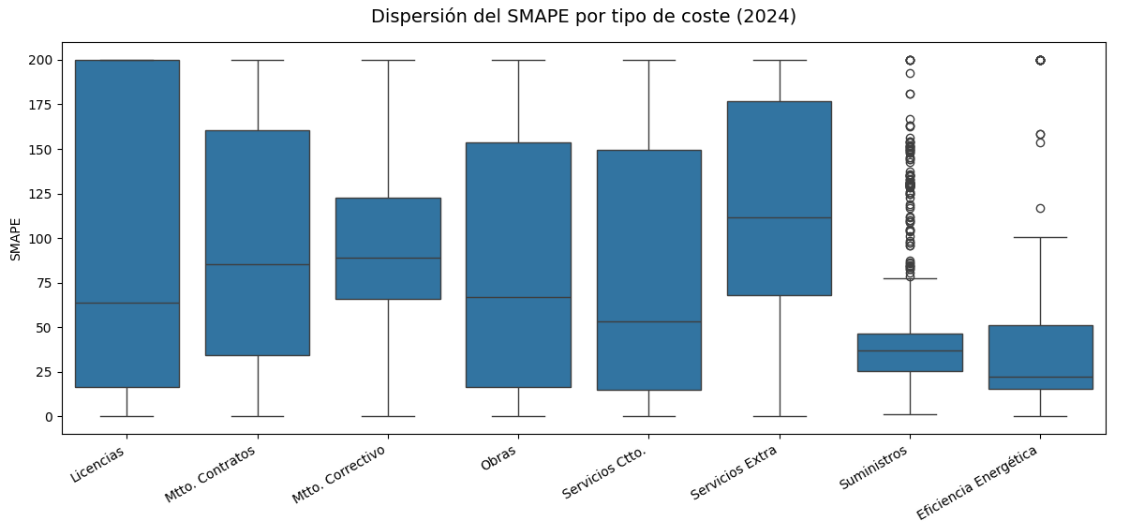

Ejemplo 5: Con el modelo resultado de la estrategia 3, el boxplot de SMAPE por tipo de coste evidencia la fuerte inestabilidad estructural de las series. Categorías como Licencias, Obras, Servicios Ctto. y Servicios Extra presentan una dispersión muy amplia y valores cercanos al máximo (200), lo que refleja comportamientos muy heterogéneos: en algunos casos el modelo acierta, pero en otros falla de forma grave. En cambio, Suministros y Eficiencia Energética muestran una distribución mucho más concentrada y valores de error bajos, indicando mayor estabilidad en la predicción. Mantenimiento Correctivo y Mantenimiento Contratos se sitúan en una posición intermedia, con cierta variabilidad pero sin extremos tan acusados. En conjunto, la gráfica confirma que solo una parte reducida de las series son realmente estables, mientras que la mayoría presenta errores altos y dispersos, reforzando la justificación de la Estrategia 3 y la necesidad de aplicar mecanismos de gobernanza para controlar estas desviaciones.

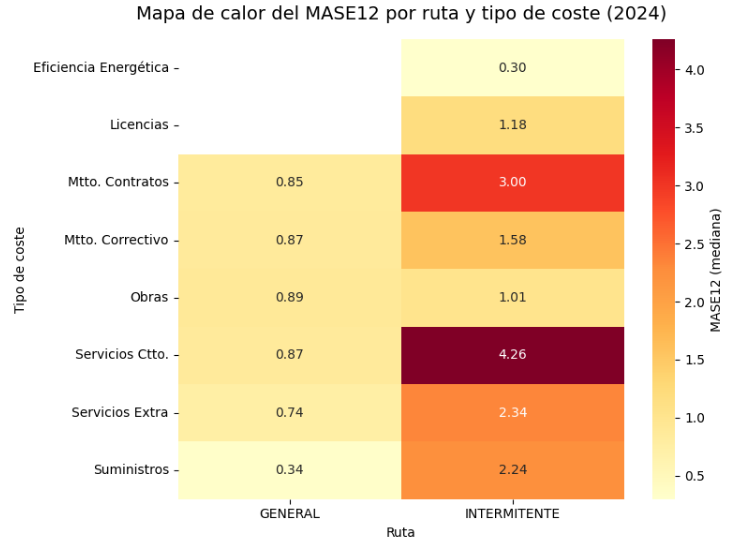

Ejemplo 6: Con el mismo modelo, se observa un mapa de calor del MASE12 por ruta y tipo de coste que muestra de forma muy clara cómo la intermitencia dispara los errores de predicción. En las series generales, los valores de MASE12 se mantienen cercanos o incluso por debajo de 1, lo que indica que el modelo suele superar al baseline estacional. Sin embargo, en las series intermitentes el error aumenta considerablemente en casi todas las categorías. Los casos más críticos son Servicios Ctto. (4.26) y Mtto. Contratos (3.00), seguidos por Servicios Extra (2.34) y Suministros (2.24), todos claramente peores que la referencia. Solo Eficiencia Energética mantiene un valor bajo incluso en intermitente (0.30), lo que la convierte en la categoría más estable. En conjunto, el gráfico confirma que la inestabilidad estructural detectada en la Estrategia 2 se concentra sobre todo en los costes con mayor intermitencia, lo que refuerza la necesidad de políticas de gobernanza robustas en la Estrategia

-

Uso de las Métricas en el Proyecto

Las métricas de validación no se usaron de forma aislada, sino que cumplieron un rol específico en cada estrategia:

-

Estrategia 1 (Diagnóstico inicial):

Se emplearon principalmente MAE y WAPE para mostrar el bajo rendimiento de los modelos ingenuos (Naive1, SNaive12) y justificar la necesidad de avanzar hacia métodos más sofisticados

-

Estrategia 2 (Análisis de Estabilidad):

Aquí las métricas tuvieron un rol crítico:

-

MASE12 permitió identificar qué series mantenían un comportamiento estable frente al baseline estacional.

-

SMAPE fue clave para cuantificar la inestabilidad en series con fuertes picos o intermitencias.

El hallazgo de que solo un 15-18% de series eran estables se fundamentó en estos indicadores.

-

Estrategia 3 (Solución robusta en 13 pasos):

Las métricas se integraron en el pipeline de gobernanza:

-

MASE12 como métrica de referencia para decidir reemplazos serie a serie.

-

WAPE como métrica agregada para validar el rendimiento global del portfolio, garantizando que nunca se empeorara respecto al baseline.

-

SMAPE y MAE

como métricas de soporte en el análisis por país y tipo de coste, ayudando a interpretar la heterogeneidad del rendimiento.

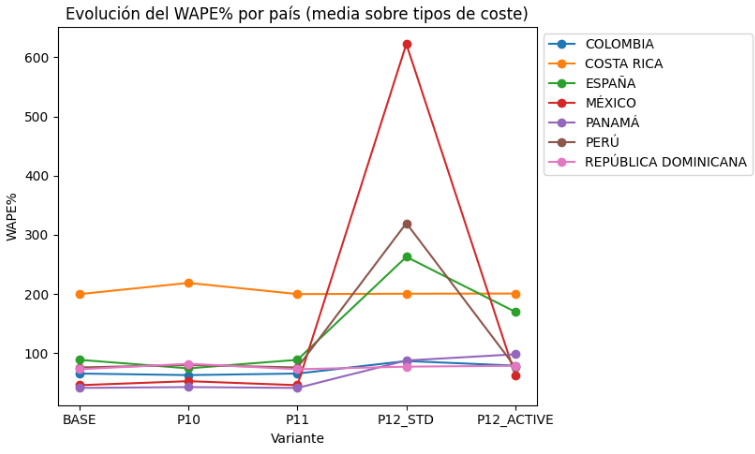

Ejemplo 7: En la mayoría de países se observa un comportamiento relativamente estable en las variantes BASE, P10 y P11, con pequeñas oscilaciones que no alteran sustancialmente el nivel de error. Sin embargo, con la variante P12_STD se produce un empeoramiento muy pronunciado en casi todos los países, destacando México con un pico extremo de más de 600%, seguido por Perú y España, que también experimentan subidas fuertes. Este comportamiento evidencia la inestabilidad introducida por esa variante.

En conjunto, cada métrica aportó en distintos niveles de decisión: diagnóstico inicial (E1), justificación de la complejidad (E2) y control de gobernanza en producción (E3). La interpretación de los resultados fue mucho más clara al complementarse con visualizaciones que hicieron visibles los patrones de error y su distribución en los distintos segmentos del portfolio.

Aunque el equipo de FM de FerMar S.L. ya utilizaba su método híbrido como referencia para realizar sus previsiones, este no lo podemos considerar un baseline estadístico válido de referencia, ya que combina reglas manuales y carece de un marco replicable. Por ello, en el proyecto se adoptó SNaive(12) como punto de partida oficial (baseline del diagnóstico inicial), siguiendo las buenas prácticas en forecasting. Este modelo permite establecer un suelo metodológico sólido y comparable contra el que contrastar la gobernanza y las variantes avanzadas. En el Anexo 4 se muestra la evolución de los distintos modelos predictivos y cómo cada uno fue reduciendo progresivamente el error hasta alcanzar el modelo final de la Estrategia 3.